在夙昔的10年间lissa_sex5 chaturbate, 谋略机处理才能的提高、数据集的扩大和算法准确性的进步激动了东谈主工智能(artificial intelligence, AI)期间的当先[1]. 跟着越来越多的AI期间从实验室走向产业界, 基于AI期间构建的软件系统也被无为应用于医疗、工业、涵养等各领域[2]. AI系统在这些应用领域中展现出新颖且出色的性能, 其适用的范围和场景都在以创新性的时势赶紧扩大. AI系统提供的许多创新功能, 如自动驾驶, 是前所未见的; AI系统愚弄的无数数据是夙昔不曾被使用的. 可是, 新兴的事物总易遇到质疑, 弘大的才能需要受到更严格的抵制. AI所体现出的优秀特点也导致了社会对于AI系统简直性的无为商量, 这些商量触及东谈主工智能系统的阴私性、公谈性、安全性等多个方面. AI系统基于无数数据建立影响社会的司法和行动, 如若在数据中存在偏见, 则AI系统会存在公谈性的问题. 举例, 好意思国法院基于AI展望再犯概率的系统被证实对黑东谈主存在偏见[3]; 顶点光照条款会影响视觉识别系统, 进而影响自动驾驶系统的安全[4]; 对东谈主脸识别系统的坏心障碍可能会导致用于检会的个东谈主图像的走漏[5]. 肖似问题正在“东谈主本主义的东谈主工智能(human-centered AI, HCAI)”“东谈主工智能伦理(AI ethics)”“简直东谈主工智能(trustworthy artificial intelligence)”等主题下被无为热议[6-8].

为了有用措置AI系统在本质应用中存在的问题, 学术界、产业界以及政府组织都在密切温情AI系统的简直性, 构造简直的AI系统应手脚其取得愈加无为应用的前提. 连年来, 简直AI领域涌现了无数圭臬、指南等模范性文献. 外洋圭臬化组织(International Organization for Standardization, ISO)的期间回报ISO TR 24028[9]分析了影响AI系统简直性的要素并从公谈性、透明性、问责性和可控性等方面商量了提高AI系统简直性的方法. 欧盟提议了《简直AI伦理指南(ethics guidelines for trustworthy AI)》[10], 建议通过尊重东谈主类自治, 伤害防止, 公谈性, 可解释性等4项原则监管AI系统, 并提议了《简直AI评估指南(assessment list for trustworthy artificial intelligence, ALTAI) 》[11]用于匡助企业或其他组织评估AI系统的开发、部署、采购和使用是否恰当《简直AI伦理指南》的相干原则. 中国信息通讯辩论院和京东探索辩论院于2021年发布的《简直东谈主工智能白皮书》[12]从落实AI治理共鸣的角度启程, 围绕可靠可控、透明可释、阴私保护以及明确包袱等方面, 将各项要求引入AI系统研发的全经由.

简直AI雷同引起了学术界的无为温情. 简直是一个抽象的倡导, 要贯通并进一步兑现简直, 需要从具体的与简直相干的质料属性起头. 自2017年以来, 涌现了无数对于简直AI系统质料属性及实践的二级辩论(secondary study). 二级辩论是指评价与特定辩论问题相干的统肃清级辩论(primary study)的辩论, 目的是详细与特定辩论问题相干的凭证; 其中一级辩论是指视察特定辩论问题的劝诫辩论(empirical study)[13]. 但是这些二级辩论都有着一定的局限性, 它们商量了简直AI系统的一个或多个质料属性, 但掩盖范围不够全面. 举例, 文献[14]仅在欧盟的4项原则下[10]商量了简直AI系统的质料属性, 枯竭对证料属性的辨析以及对相干实践的商量. 文献[15]仅温情安全性和鲁棒性两个简直AI系统的质料属性及相干实践, 坚苦对简直性全面的商量. 文献[16]仅商量了公谈性、阴私性、可解释性、可问责性和可接受性5项要求偏激相干的保险实践, 坚苦对更多质料属性的辩论, 同期, 也未商量这些质料属性的度量评估方法. 更多的二级辩论, 如文献[17-19]仅聚焦于单个质料属性.

为了对AI的简直建立一个愈加系统且全面的意志, 本文开展了一项三级辩论(tertiary study)来蚁集并分析现存与简直AI相干的二级辩论, 具体从简直AI系统的二级辩论近况、质料属性、评估度量方法、保险改进实践等4个方面开展了辩论. 三级辩论是将二级辩论的输出手脚输入的综述性辩论[20,21]. 当一个辩论主题上的二级辩论饱和多时, 三级辩论不错掩盖更无为的凭证并从更高的抽象端倪开展辩论, 为辩论者建立更系统性地贯通和定位相干的二级辩论提供匡助, 弥补单项二级辩论对问题意志不全面及弱化的单项辩论中可能引入的偏见[22,23].

本文检索、挑选和分析了34项相干的二级辩论[14-19,24-51], 具体而言, 主要孝敬包括: (1)本文揭示了简直AI系统的质料属性及相干实践的二级辩论的辩论近况. (2)总结了现存二级辩论中商量的质料属性, 按照简直AI的基本原则、质料属性及子属性的端倪结构建立了简直东谈主工智能系统的质料属性框架. (3)梳理了现存的简直性评估度量方法. (4)梳理了现存的简直性保险改进实践.

本文第1节请教本三级辩论的辩论问题及所给与的辩论方法. 第2节至第5节对本辩论的4个辩论问题分别进行回话. 第6节基于辩论收尾进行商量. 第7节商量本文的效度挟制. 第8节对本文进行总结.

1 辩论方法本辩论开展的是以二级辩论为辩论对象的三级辩论. 二级辩论广大指以一级辩论为对象开展的辩论, 包括给与系统性文献综述(systematic literature review, SLR)、映射辩论(mapping study, MS)、一般综述(review)等方法的综述性辩论[13]. Kitchenham等东谈主[20, 21]将三级辩论界说为“使用一个学科内的二级辩论的输出手脚输入的辩论”. 本辩论的开展降服Kitchenham等东谈主对于软件工程领域系统性文献综述的指南[13]. 现在, 该指南[13]刻画的系统性文献综述方法被无为应用于软件工程领域的二级辩论和三级辩论中, 是一种较映射辩论和一般综述愈加系统且严谨的辩论方法. 两名硕士辩论生和他们的两名导师手脚辩论东谈主员参与了这项辩论.

本节主要请教辩论过程中所给与的辩论方法. 启程点提议本三级辩论的辩论问题(第1.1节), 其次刻画文献的检索和筛选过程(第1.2节), 临了刻画本辩论的数据抽取与分析过程(第1.3节).

1.1 辩论问题为了分析简直AI领域内的相干二级辩论的辩论近况, 对简直AI的质料属性与相干实践建立系统性的贯通, 本文提议了以下4个辩论问题(research questions, RQs).

RQ1: 现存简直东谈主工智能系统相干二级辩论的辩论近况怎么?

RQ2: 现存二级辩论中商量了哪些与东谈主工智能系统的简直性相干的质料属性?

RQ3: 现存二级辩论中商量了哪些东谈主工智能系统的简直性(即各质料属性)的评估度量方法?

RQ4: 现存二级辩论中商量了哪些东谈主工智能系统的简直性(即各质料属性)的保险改进实践?

其中, RQ1旨在对简直AI相干的二级辩论的发表趋势, 发表渠谈以及辩论范围等建立系统的贯通. RQ2旨在调研面前简直AI相干的二级辩论中商量的质料属性间的互异、辩论及端倪关系, 从而建立一个全面的AI系统简直性的质料属性框架. RQ3和RQ4分别旨在对AI系统的简直性(即各质料属性)的评估度量方法和保险改进实践建立较为全面的意志, 识别出辩论的热门和空缺, 进而挖掘出改日可能的辩论标的.

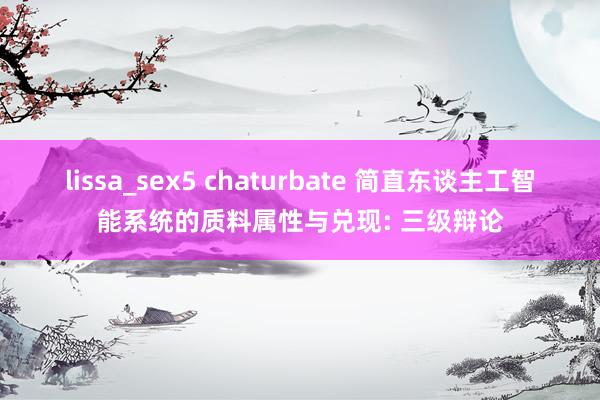

1.2 相干文献蚁集本辩论对现存二级辩论文献的蚁集过程如后文图1所示, 包含手动检索、自动检索、文献筛选和滚雪球检索等4个花样. 为了尽可能裁减文献检索过程中遗漏相干文献的风险, 本文华纳了基于准黄金圭臬(quasi golden standard, QGS)的检索计谋[52], 具体的文献检索过程包括手动检索、自动检索以及滚雪球检索3个花样, 其中滚雪球检索过程中包含了对文献的筛选. 文献的筛选由两名硕士辩论目生别稳固完成, 他们之间的任何互异都会和导师进行商量, 统统被纳入的文献都由导师进行最终阐发. 本辩论最终纳入了34篇相干文献. 需要说明的是, 文献蚁集过程中莫得对文献属于二级辩论或三级辩论加以限制, 最终统统识别到的文献均为二级辩论, 即现在还莫得一篇已发表的对于简直AI的三级辩论. 以下将伸开先容文献蚁集过程的各具身花样.

Fig. 1 Study collection process

图 1 相干文献蚁集过程

1.2.1 手动检索

Fig. 1 Study collection process

图 1 相干文献蚁集过程

1.2.1 手动检索

手动检索基于领域内综述类文献的顶级期刊ACM Computing Surveys进行. 手动检索的主要目的是为后续的自动检索设想愈加全面且准确的检索字符串提供基础. 同期, 使本辩论的统统参与者对辩论问题和辩论范围建立清澈且一致的贯通, 并进一步建设文献弃取圭臬. 咱们一一浏览了出书时候在2018年至2022年3月之间的文献并进行筛选, 共蚁集到了6篇对于简直AI质料属性的二级辩论.

1.2.2 自动检索在笃定自动检索的字符串时, 主要参考了手动检索得到的6篇文献中的要害词. 启程点笃定的是要害词“简直”和“东谈主工智能”, 即“Trustworthy”和“AI”及它们的近义词. 进一步地, 蚁集了这6篇文献以及现存的与简直AI相干的7项模范性文献中触及的质料属性手脚要害词, 这些模范性文献包括ISO TR 24027[53], ISO TR 24028[9], ISO TR 24029[54], IEEE 3652.1[55], IEEE P7001[56], ALTAL[11]. 由于本文的辩论对象是二级辩论, 是以加多了“Review”“SLR”等要害词. 最终笃定的检索字符串如下所示.

(“Trustworthy” OR “Trustworthiness” OR “Quality Attribute” OR “QA” OR “Reliabl*” OR “Transparency” OR “Privacy” OR “Secur*” OR “Safe*” OR “Fair*” OR “Robust*” OR “Account*”) AND

(“AI” OR “Artificial Intelligence” OR “Machine Learning” OR “Deep Learning”) AND

(“Review” OR “Mapping” OR “SLR” OR “SMS”)

本文检索了4个文献数据库, 包括IEEE Xplore, ACM Digital Library, Science Direct, Scopus. 其中Scopus是最大的同业评议文献数据库, 且收录汉文文献, 不详对前3个数据库进行有用的补充, 该阶段在每个检索源中得回的检索收尾如表1所示, 去重后共检索到634篇文献. 在手动检索阶段得到的6篇文献均包含在这634篇文献中, 说明检索字符串具有较高的有用性.

为了清除已得回文献鸠合中与辩论问题不相干和关联度较小的文献, 本文界说了如表2所示的纳入和清除圭臬. 唯独炫夸统统纳入圭臬且莫得恰当随便一条清除圭臬的文献才会被纳入最终的文献鸠合.

根据上述纳入/清除圭臬, 本文进行了文献的筛选, 具体筛选过程包括撮要浏览和全文通读两个阶段. 撮要浏览阶段, 通过浏览文献的标题、要害词和摘抄以判断它们是否恰当纳入的圭臬. 在这之后, 咱们通读了炫夸纳入圭臬的文献, 并列除了那些恰当随便清除圭臬的文献. 在进行文献筛选时, 每篇文献的筛选都由两位辩论东谈主员稳固完成, 每一篇存在争议的文献都由他们的带领者评审并进行商量以达成共鸣. 需要特别说明的是, 根据中国科学院发布的《外洋期刊预警名单》, 清除了2篇来自IEEE Access的二级辩论. 通过文献筛选过程, 共保留了30篇二级辩论.

1.2.4 滚雪球检索.在识别到的30篇文献的基础上, 本辩论通过谷歌学术进行了滚雪球(snowballing)来进一步检索相干文献, 包括前向滚雪球, 后向滚雪球和根据作家信息滚雪球3个阶段. 其中, 前向滚雪球是检索援用了已识别的30篇文献的文献, 后向滚雪球是检索已识别文献的参考文献, 根据作家信息滚雪球是检索文献第一作家的其他相干文献. 在该阶段, 本辩论降服Wohlin[57]的建议, 反复迭代滚雪球的过程, 直到不再发现新的文献为止. 此外, 除了检索除外, 本阶段还包含了前述的文献筛选. 滚雪球阶段新发现了4篇文献. 最终, 共纳入了34篇二级辩论[14-19, 24-51]手脚本辩论的对象.

大伊香蕉人在线观看 1.3 数据抽取与分析根据辩论问题, 本文界说了数据抽取表格, 如表3所示, 从而圭臬化地获取每篇文献中所回报的本辩论所需的信息. 为了减少数据抽取过程中个东谈主偏见对辩论收尾的影响, 在数据抽取过程中, 一位辩论东谈主员抽取每一项辩论的数据项, 另一位辩论东谈主员对抽取收尾进行考据, 同期如期与他们的导师进行商量.

在对抽取出的数据项进行分析时, 给与了定量分析和定性分析的方法. 定量分析方法用于获取文献鸠合中二级辩论的趋势及散布等信息. 对于抽取项D1–D4, 给与统计方法来得回文献散布和发表趋势的定量收尾. 对于数据抽取项D5–D8, 给与了定性的主题分析方法[58], 以得回二级辩论中触及的质料属性以及相干的实践. 为了救济主题分析, 本文华纳了数据编码方法, 即一种通过象征和组织定性数据以识别主题以及主题之间的关系的方法[59], 使用敞开编码和轴向编码从索取出的数据项中聚类得到高抽象端倪的倡导. 在进行数据合成时, 由两位辩论东谈主员分别对索取出的原始文本进行敞开编码. 在所少见据完成运转编码后, 本文对得回的编码进行分析和比较, 进而将它们组合成主题. 最终得回的主题都经过了两位辩论东谈主员的交叉评审, 任何分歧都与他们的导师进行商量, 直到达成共鸣.

2 辩论近况(RQ1)本节中简要概述了本三级辩论所纳入的二级辩论的总体情况和辩论范围, 以给出RQ1的回话.

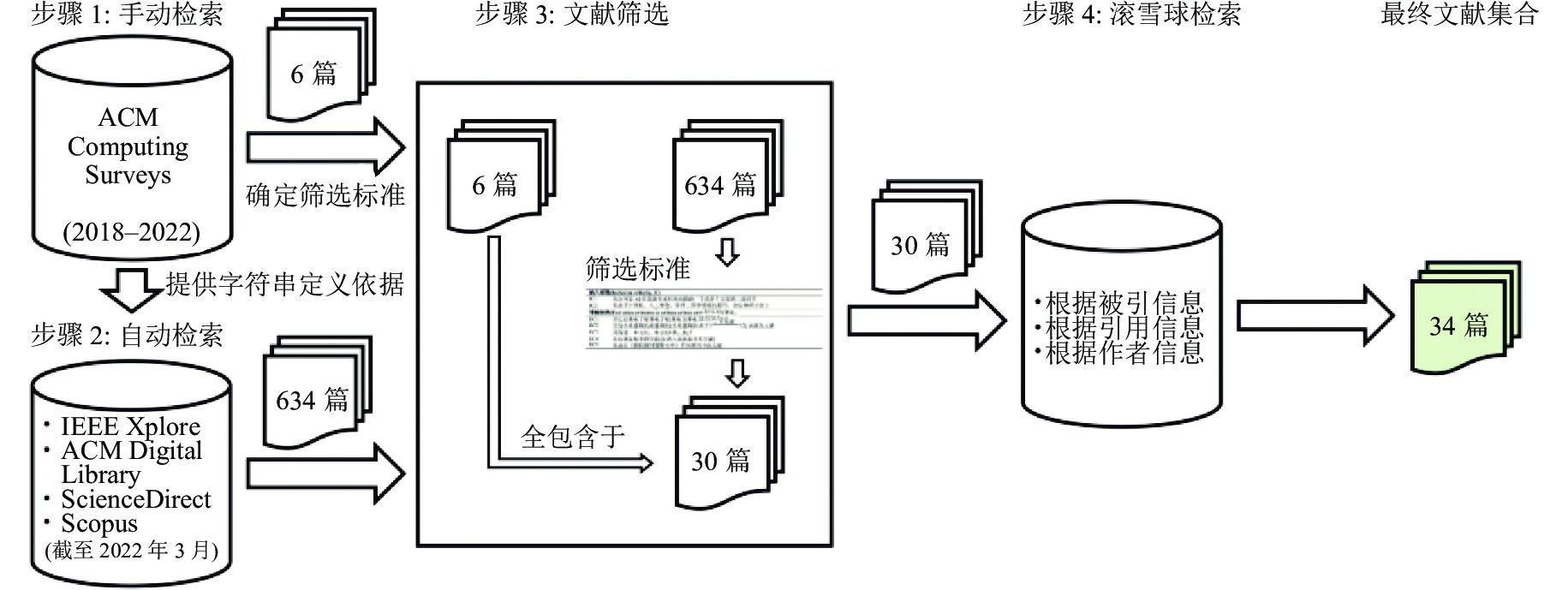

2.1 总体情况本文纳入的34篇二级辩论中, 包含27篇英文文献和7篇汉文文献. 以下将从年份散布、地舆散布、渠谈散布3个方面进行统计分析.

● 年份散布. 图2展示了纳入文献的发表年份散布情况. 诚然自动检索时的检索范围限制2022年3月, 但从图2中不错看出, 在2016年之前还莫得相干二级辩论被发表. 简直AI相干的二级辩论始于2017年, 且发表数目在2017至2021年呈逐年增长的趋势, 且2022年截止到3月发表的文献数目已接近2021年全年一半的数目. 这一方面标明AI的简直的问题已愈发受到辩论东谈主员的温情; 另一方面也说明简直AI是一个问题繁茂的辩论标的. 纳入的文献中, 发表最早的汉文二级辩论始于2019年, 且在此后雷同保合手平稳的发表趋势.

Fig. 2 Year distribution of publications

图 2 发表年份散布情况

Fig. 2 Year distribution of publications

图 2 发表年份散布情况

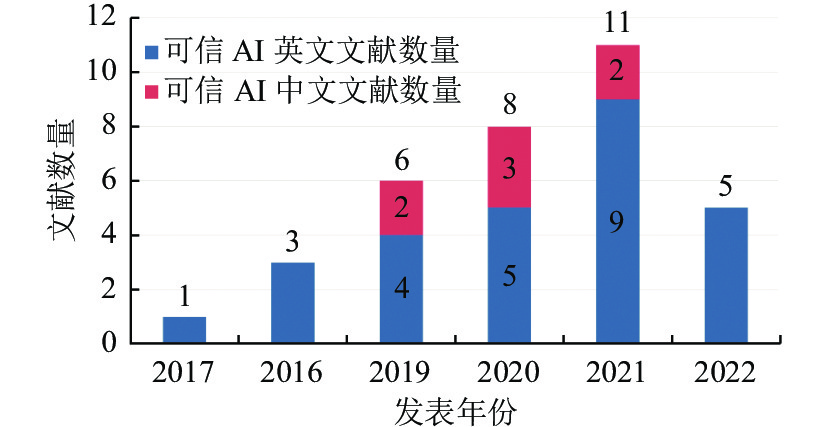

● 地舆散布. 图3展示了纳入文献的第一作家所属辩论机构的地舆散布情况. 寰宇除了南好意思洲和南极洲(无国度)均有辩论者从事简直AI相干的二级辩论. 从占比来看, 来自亚洲的辩论者占比最高(50%), 这成绩于中国辩论者发表的二级辩论占总体的32%. 这应该与中国的学术界和工业界连年来在AI领域两面着花、鼎沸发展的近况密切相干.

Fig. 3 Geographical distribution of research institutions to which the first author belongs

图 3 第一作家所属辩论机构的地舆散布情况

Fig. 3 Geographical distribution of research institutions to which the first author belongs

图 3 第一作家所属辩论机构的地舆散布情况

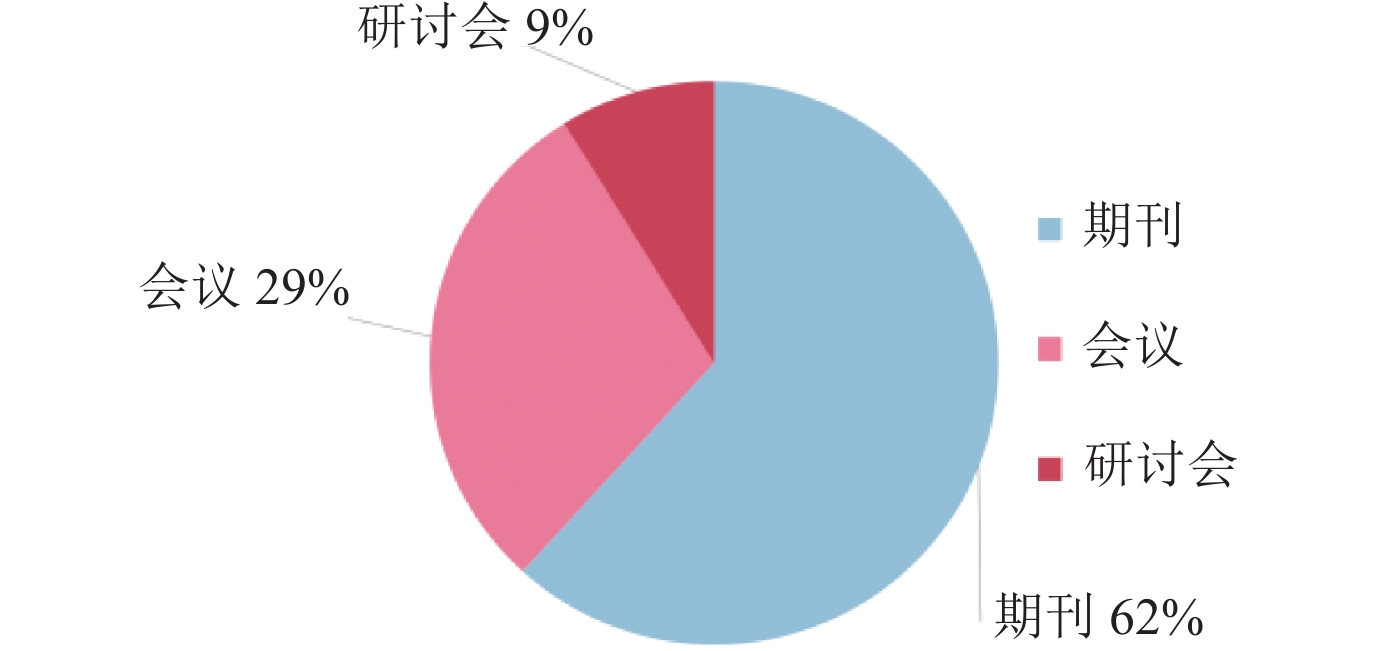

● 渠谈散布. 图4展示了纳入文献在期刊(Journal), 会议(Conference)和研讨会(Workshop)这3种发表渠谈的散布情况. 其中半数以上(62%)为期刊论文, 29%为会论说文, 唯独3篇为研讨会论文. 对于具体的期刊或会议, 总体发表渠谈较为分散. 但统计发现, 发表在国表里高水平刊物上的二级辩论占比更高. 其中6篇英文论文发表在了综述类论文的外洋顶级期刊《ACM Computing Surveys》上. 统统纳入的汉文文献均发表在国内顶级期刊上, 其中4篇发表在《软件学报》, 3篇发表在《谋略机辩论与发展》.

Fig. 4 Publication venue distribution

图 4 发表渠谈散布

2.2 辩论范围

Fig. 4 Publication venue distribution

图 4 发表渠谈散布

2.2 辩论范围

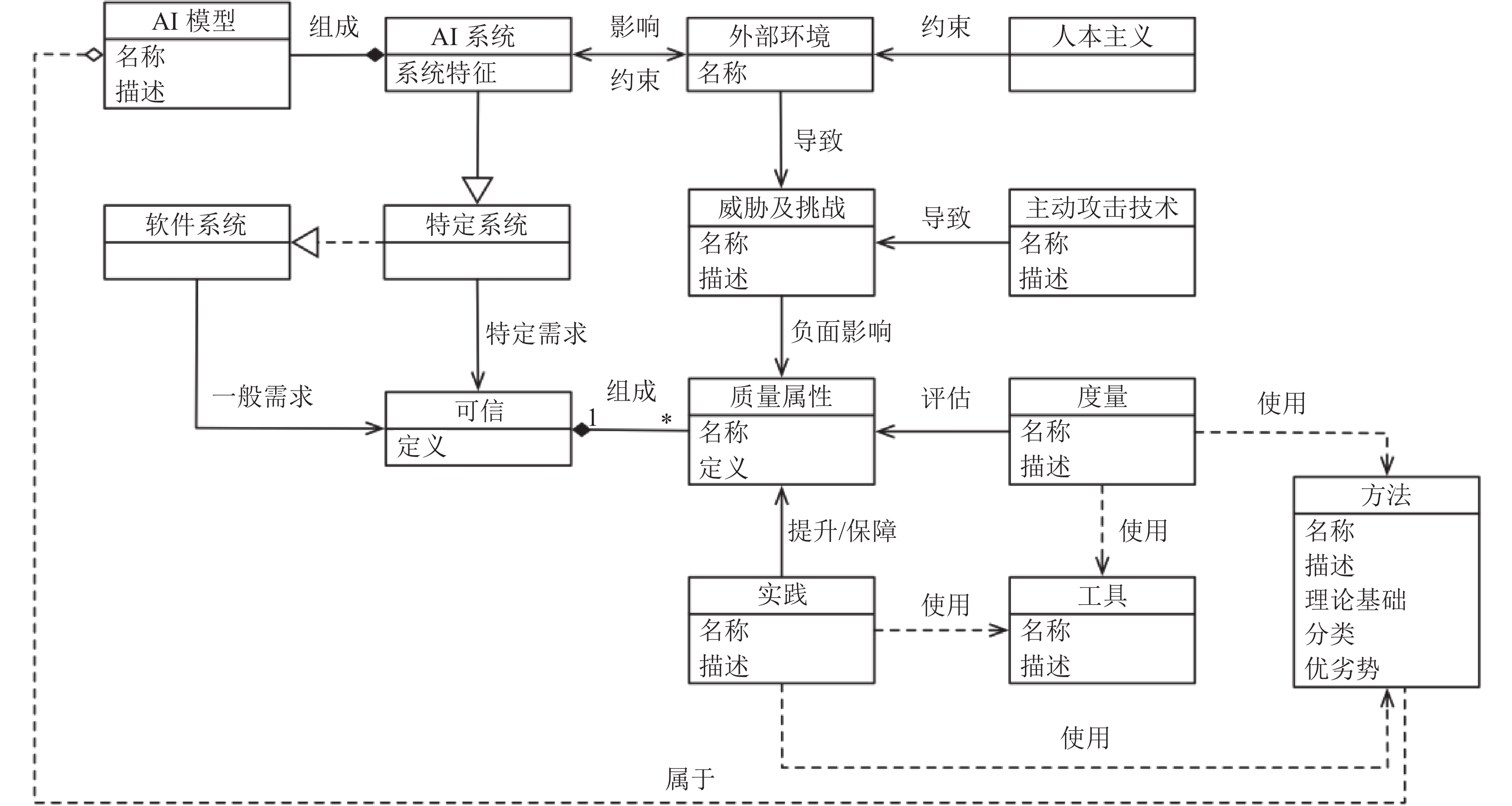

本文识别并详细了现存二级辩论中对于简直的辩论对象(温情点), 建立了简直东谈主工智能辩论范围元模子, 如图5所示. 元模子以软件系统及简直为中枢, 围绕AI系统的简直, 即一种特定的软件系统的简直伸开. 简直手脚软件系统的一般需求广大包含多个不错由质料属性暗示的特征构成, 相干的实践不错进步或保险相应的质料属性, 质料属性的评估需要使用一定的度量, 每一类的实践和度量广大包含具体的方法, 同期也需要使用一定的器具. 对软件系统而言, 主动障碍期间和软件所处的外部环境会导致特定的挟制和挑战, 进而对系统的质料属性变成负面影响. AI系统手脚特定的软件系统, 其简直性存在着一定的特殊性: 启程点, 不同于传统软件, AI模子是AI系统的一个进击构成部分; 其次, 由于AI系统的外部环境的特殊性, 其需要洽商以东谈主本主义为主的伦理谈德对环境的抵制. 挟制与挑战除了源于外部环境, 还可能来源于一些黑客的主动障碍. 简直性、挟制及挑战等最终都指向不详刻画简直性的具体质料属性. 更进一步的辩论重心是, 给与奈何的度量方法或使用奈何的器具不详评估具体质料属性对于简直的炫夸进程; 以及给与何种实践不详保险以至改进具体质料属性对于简直的炫夸进程. 实践可能基于具体的器具或方法, 具体评估或保险方法可能会应用一些AI模子或算法.

Fig. 5 A metamodel for the research category of trustworthy artificial intelligence

图 5 简直东谈主工智能辩论范围元模子

Fig. 5 A metamodel for the research category of trustworthy artificial intelligence

图 5 简直东谈主工智能辩论范围元模子

对于雷同的辩论对象, 不同辩论可能从多种不同的角度开展辩论, 是以本文鉴戒了文献[60]中的方法, 即给与5W+1H模子进一步分析了现存二级辩论对图5中各辩论对象的辩论情况, 如表4所示. 在表4中, Wt, Wy, Wo, Wn, Wr, H分别暗示What, Why, Who, When, Where, How. 本文参考了文献[61,62]中的界说, 并基于曲折文, 界说如下.

What (Wt): 有哪些辩论对象? 它们是什么? 举例, 文献[26]的一个辩论问题是“有哪些用于开发和评估AI系统的器具”.

Why (Wy): 为什么兑现这些辩论对象? 举例, 文献[16]在辩论质料属性时, 辩论了“为什么简直AI需要这些质料属性”.

Who (Wo): 谁提议或兑现了这些辩论对象? (仅仅援用了作家不属于该类别, 应有如机构散布等肖似的对于作家的分析). 举例, 文献[37]中的一个辩论问题是“谁在指挥基于AI的软件的质料的辩论(学术界, 工业界, 及两者的联接)”.

When (Wn): 在什么情况下洽商或使用这些辩论对象? 举例, 文献[27]对于公谈性的保险改进方法, 辩论了“不同AI模子应该给与何种方法”.

Where (Wr): 在什么AI系统开发阶段洽商或使用这些辩论对象? 举例, 文献[16]在辩论多种质料属性的保险改进实践时, 辩论了“各实践应该映射到AI系统开发的哪些阶段(如, 建模前、建模过程中庸建模后) ”.

How (H): 怎么兑现或怎么应用这些辩论对象? 举例, 文献[24]的一个辩论主见是“怎么通过实践来保险AI系统简直性”.

举例文献[27]在方法这一列为“Wt, Wr, Wn”, 暗示针对方法辩论了现存一级辩论给与了哪些方法(Wt), 这些方法适用的场景和使用的条款是什么(Wn), 以及这些方法应用于AI系统开发的哪个阶段(Wr). 举例文献[14]在简直这一列为“Wy, H”, 暗示针对简直辩论了为什么需要简直(Wy)和怎么兑现简直(H). 广大, 是什么(Wt)是最基本的辩论问题, 绝大部分辩论都会启程点从是什么的角度商量一个问题. 对于为什么(Wy)的问题更多是在辩论动机中仍是请教的, 尤其是对于实践、方法等辩论对象, 一般不会从为什么的角度进行辩论. 对于怎么兑现或怎么应用(H)这类较为细节的问题, 在二级辩论中雷同少有辩论, 因为广大, 这类问题会被抽象为在什么情况下洽商或使用(Wn)以及在什么阶段洽商或使用(Wr)的问题. 仅有一篇文献[37]有意成就辩论问题以分析作家信息(Wo), 可是, 这诚然是一个简直莫得辩论难度的问题, 但广大又是读者想了解的信息. 对于具体的辩论对象, 不错看到, 更多的辩论温情的是挟制及挑战和大意挟制及挑战的方法, 这是由于大部分辩论温情的都是安全性和阴私性的主题, 而这两个质料属性触及繁多挟制及基于不同期间道路的大意措施, 将在后续章节具体商量.

RQ1要点总结: 简直AI的二级辩论始于2017年并呈平稳增长趋势; 寰宇除了南好意思洲和南极洲(无国度)均有辩论者从事简直AI相干的二级辩论. 已有简直AI的二级辩论主要温情点在于质料属性的保险改进方法及挟制与挑战, 可是温情质料评估方法的辩论较少, 从为什么(Why)的角度商量问题以及对一级辩论的作家信息(Who)进行分析的二级辩论也相对较少.

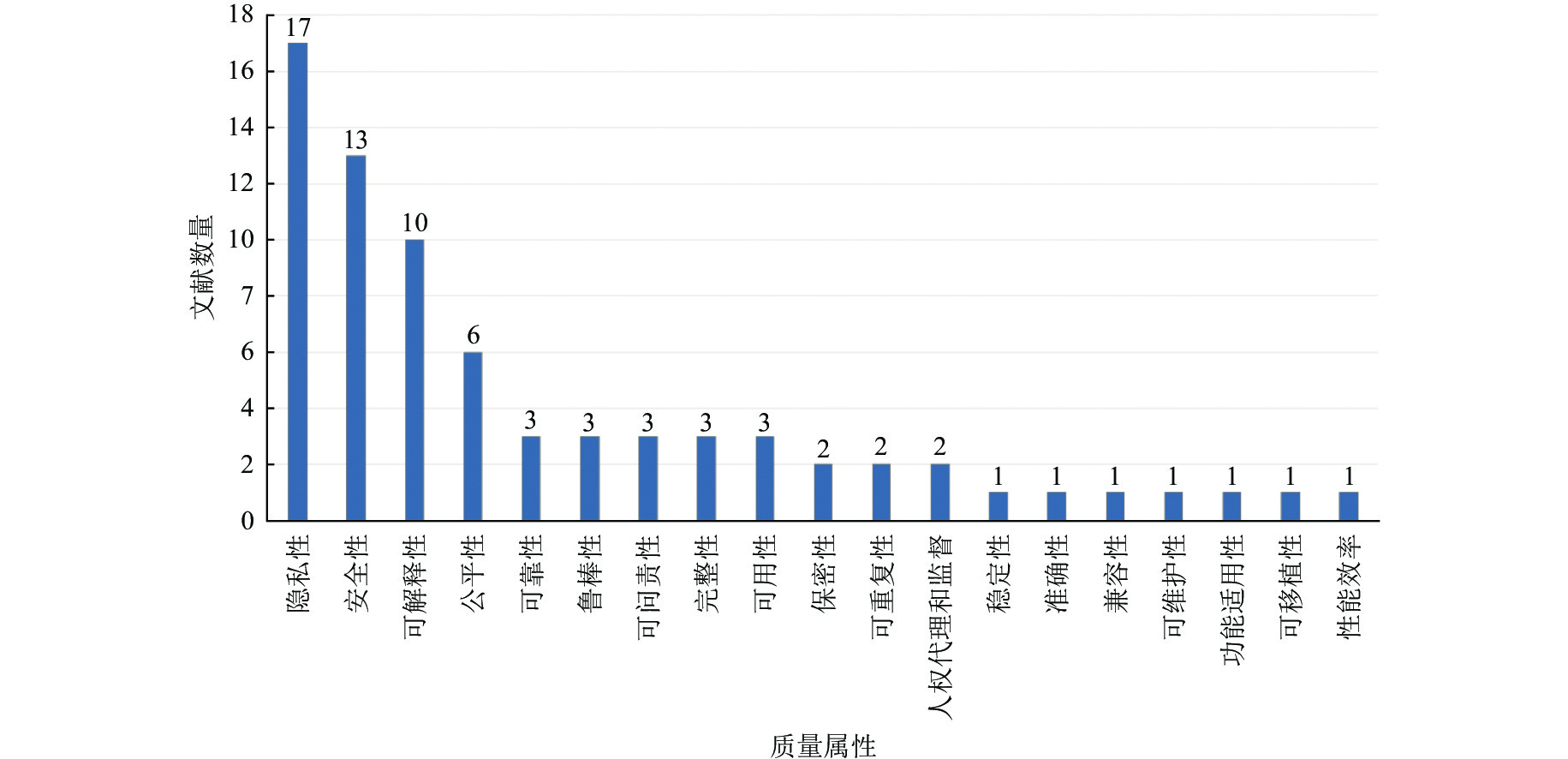

3 简直东谈主工智能系统的质料属性框架(RQ2)本文从现存二级辩论中共鸣别到了21种简直相干的质料属性, 其被辩论的频率散布如图6所示, 其中阴私性、安全性和可解释性等与AI系统区别于一般软件系统的特征相干的质料属性是被辩论最多的, 而与一般软件系统的简直相干的可贵重性、可移植性等质料属性仅在一项二级辩论[37]中进行了商量. 欧盟发布的简直AI伦理谈德指南[10]中建议简直AI系统需炫夸4项基本原则, 分别是尊重东谈主类自治原则(the principle of respect for human autonomy), 伤害防止原则(the principle of prevention of harm), 公谈性原则(the principle of fairness)以及可解释性原则(the principle of explicability). 在识别到的21种质料属性中, 有15种不错分类到这4项原则中, 其中安全性包含了3个子属性, 可解释性包含了1个子属性. 而其余6种质料属性属于一般软件系统的简直性需求, 与ISO/IEC 25010:2011[63]中提议的质料模子相符. 参考简直AI伦理谈德指南[10]和ISO/IEC 25010:2011[63], 以及二级辩论中的刻画, 本文构建了一个简直AI质料属性框架, 如图7所示. 需要说明的是, 在ISO/IEC 25010:2011[63]中提议了8种软件质料属性, 分别是兼容性, 可贵重性, 功能适用性, 可移植性, 性能效果, 可靠性, 易用性和安全性. 其中可靠性和安全性均属于伤害防止原则的范围, 但本质上本辩论只识别到了AI系统在安全性有特定的需求, 而在可靠性上的需求与一般软件一致. 此外, 本文将不属于4项原则的其他质料属性分类到了一般软件质料属性类别中. 本文所提议的简直AI质料属性框架与ISO/IEC 25010:2011[63]中的质料属性框架之间的互异, 不错响应出相较于一般软件系统, 对AI系统的简直提议的新的要求. 以下将对各质料属性按框架中的5种类别进行伸开先容.

Fig. 6 Number distribution of studies related to each quality attribute

图 6 质料属性相干辩论数目散布

Fig. 6 Number distribution of studies related to each quality attribute

图 6 质料属性相干辩论数目散布

Fig. 7 A quality attribute framework for trustworthy artificial intelligence systems

图 7 简直东谈主工智能系统的质料框架

3.1 尊重东谈主类自治原则

Fig. 7 A quality attribute framework for trustworthy artificial intelligence systems

图 7 简直东谈主工智能系统的质料框架

3.1 尊重东谈主类自治原则

东谈主工智能系统的用户应不详保合手充分和有用的自我决议, AI系统的设想应该以补充和增强东谈主的才能为目的[10]. 在获取到的质料属性中, 唯唯独种质料属性, 即东谈主类代理和监督不错映射到该原则下.

● 东谈主类代理和监督(human agency and oversight). 有2篇文献[14, 16]商量了这一质料属性, 其汉文献[14]将尊重东谈主类自治原则视为设想简直东谈主工智能系统最进击的原则. 文献[14, 16]均指出东谈主工智能系统应该赋予东谈主类新的权力而不是取代东谈主类. 详细两项辩论[14, 16]中的界说, 本文将东谈主类代理和监督界说为东谈主工智能系统应该恒久处于东谈主类的戒指之下以幸免系统对东谈主的人命健康安全或其他基本权力变成危害. 东谈主类代理和监督质料属性的保险和改进, 在于措置东谈主工智能系统对东谈主类行动变成影响的问题. 应基于风险以及社会和环境影响要素, 保险和尊重东谈主类自治的基本原则, 保证东谈主类对于系统决议过程的参与达到一定进程.

3.2 伤害防止原则伤害防止原则触及3方面的要求[10], 包括: (1) AI系统不大意用户或环境变成伤害或加重伤害; (2) AI系统偏激运行环境必须是可靠的; (3) AI系统在期间上必须是健壮的. 基于上述要求, 本文将鲁棒性, 平稳性, 安全性(含守密性、无缺性、可用性等3个子属性), 可靠性, 可问责性, 阴私性, 可重复性和准确性共11个质料属性映射到该原则下.

● 安全性(security). 有13篇文献[14, 15, 17, 25, 26, 28, 31, 36, 37, 40, 43, 45, 50]商量了安全性, 其中4项辩论[14, 25, 26, 37]对安全性提议了界说性刻画. 文献[25]将守密性(confidentiality), 无缺性(integrity)和可用性(availability)视作安全性的主要主见, 据此本文将这3个主见界说为安全性的子属性. 文献[26]中指出东谈主工智能系统的安全性问题主要围绕东谈主工智能系统安全的考据与阐发问题、在易受障碍环境下的东谈主工智能模子的自我保护问题等方面. 文献[14]对安全性的刻画侧重于AI模子而不是系统的安全, 即安全性确保外部障碍不会改变或影响AI模子的决议. 文献[37]给与了ISO/IEC 25010:2011[63]中对于安全性的刻画, 即居品或系统保护信息和数据的进程, 及便于个东谈主或其他居品或系统具有与其授权类型和级别相顺应的数据视察进程. 此外, 部分辩论如文献[40, 43], 诚然莫得明确界说安全性, 但在请教安全性相干实践时, 商量了东谈主工智能系统的数据安全性.

综上lissa_sex5 chaturbate, 本文对东谈主工智能系统的安全性给出如下界说: 东谈主工智能系统扞拒犯罪独揽或障碍以保护数据、模子和其他组件免受外部障碍影响的进程, 其子属性按主见分别包括守密性, 无缺性和可用性. 其中, 守密性指系统保护检会数据中的秘密信息以及模子参数等信息以幸免误用和未经授权的视察的进程[25, 43]; 无缺性指系统防止未经授权的修改以确保系统数据一致性和准确性的进程[14, 25, 43]; 可用性则指东谈主工智能系统在面对颠倒输入、坏心输入等颠倒情况仍能提供正便就业的才能[25, 43].

● 阴私性(privacy). 有17篇文献[14-18, 25, 28-30, 36, 39, 40, 42, 43, 45-47]商量了阴私性, 这是受温情度最高的质料属性. 6项辩论[14, 16, 18, 30, 45, 46]对阴私性提议了界说性刻画. 文献[14]从AI模子的角度洽商阴私性, 指出模子的阴私性意味着AI模子应该保护它所检会的数据和使用它的用户的身份. 文献[16]温情AI系统的数据阴私, 指出阴私性确保由个东谈主分享或AI系统蚁集的敏锐数据受到保护. 文献[18]指出AI模子(专指深度学习模子)的阴私性问题与敏锐的输入数据以及分享检会等要素关系. 文献[30, 45]指出机器学习的阴私性与检会数据以及模子和模子参数等钞票不受推断、窃取和干预等影响的才能关系. 文献[46]提供了一个愈加全面的贯通, 将AI模子的阴私分为检会数据阴私、模子阴私与展望收尾阴私.

综上, 本文将阴私性界说为: 东谈主工智能系统保护用户信息, 检会数据, 模子相干信息以及决议收尾等不受窃取、推断和干扰的才能. 从给出的界说不错看出, 东谈主工智能系统的阴私性与信息安全性密切相干, 因此特等一半的二级辩论[14, 15, 17, 25, 36, 40, 43, 45]在商量阴私性的同期会商量安全性.

● 可靠性(reliability). 有3篇文献[16, 37, 40]商量了可靠性. 文献[16]将可靠性刻画为系统按预期运行的进程, 即在章程的方法内, 系统莫得任缘何障, 对沟通的输入合手续产生沟通的输出的进程. 这一界说与文献[37]中给与的ISO SQuaRE[63]中的界说肖似, 后者是系统、居品或组件在章程条款下在章程时候内实践章程功能的进程. AI系统手脚一种特定的软件系统, 也需要炫夸一般软件系统的质料属性. 由于莫得在文献中识别到对于AI系统的可靠性所专有的需求, 本文雷同建议给与ISO SQuaRE[63]中的界说.

● 鲁棒性(robustness). 有3篇文献[15, 37, 38]商量了鲁棒性. 其汉文献[37]莫得对鲁棒性提供明确的界说. 文献[15]中将鲁棒性界说为AI系统面对坏心障碍的弹性进程. 文献[38]中觉得鲁棒性是指AI模子不受障碍者影响或不合颠倒值进行失实分类的才能. 与可靠性比拟, 鲁棒性强调面对不正常输入的平稳性, 而可靠性强调行动的正确性. 与安全性比拟, 鲁棒性强调AI系统在面对扰动时保合手正常运行的才能, 而安全性强调系统幸免系统扰动而产生危害.

综上, 本文将鲁棒性界说为: AI系统面对颠倒情况时, 在软件系统层面和AI模子层面均保合手正常运行的才能.

● 平稳性(stability). 仅有1篇文献[19]商量了平稳性. 文献[19]觉得如若渺小的扰动(如数据源自己的噪声)不会对模子的决议变成误导, 则觉得该模子是平稳的. 将其彭胀到更无为的系统层面, 当系统面对扰动时模子不受误导则标明系统仍处于平稳情状.

鉴戒文献[19]的不雅点, 本文将平稳性界说为: 当AI系统面对渺小扰动时, 系统仍能保合手平稳情状的才能.

● 准确性(accuracy) 仅有1篇文献[14]商量了准确性. 文献[14]中将模子的准确性界说为模子正确展望收尾的才能, 同期文中指出AI系统的准确性应保合手在一定阈值之上以保证系统不详作念出可靠的决议.

综上, 本文将准确性界说为: AI系统提供正确决议的才能, 其准确性应保合手在一定阈值之上.

● 可问责性(accountability). 有3篇文献[14, 16, 19]商量了可问责性. 文献[14]温情AI模子的可问责性, 其指出模子的可问责性指模子向系统用户评释其所作念决议的才能. 文献[16, 19]从AI系统的层面提供了肖似的界说, 即向与系统交互的不同用户解释和评释系统的决议和行动的才能. AI系统的决议和行动是由其模子推导出来的, 因此从模子角度或从系统角度进行界说, 其酷爱是沟通的. 本文华纳文献[16, 19]中的界说.

● 可重复性(reproducibility). 有2篇文献[14, 19]商量了可重复性. 这2篇文献对可重复性的界说是相似的, 其汉文献[14]的界说愈加全面, 其从系统的角度将可重复性刻画为, 如若向系统提供沟通的输入参数和条款, 系统作念出的统统决建都可重复. 而文献[19]中从模子的角度将可重复性刻画为, 如若一个模子在沟通的数据集上运行数次, 能重复得到沟通的收尾. 文献[14, 19]中对于可重复性的刻画是一种完全可重复和完全不行重复的二元判断.

从具有统计意旨的度量的角度, 本文建议将可重复性界说为: AI系统在沟通的数据集、参数和条款上运行屡次不详得到沟通的运行收尾的进程(概率).

3.3 公谈性原则公谈性原则要求东谈主工智能系统的开发、部署和使用必须公谈. 尽管公谈性存在不同的界说, 但公谈性的实质是要求利益和资本的对等, 通过公谈分派以确保个体或群体不受不公谈的偏见和歧视[10]. 在识别到的统统质料属性中, 唯唯独个质料属性, 即公谈性不错映射到该项原则下.

● 公谈性(fairness). 有6篇文献[14, 16, 26, 27, 48, 49]商量了公谈性或相似倡导. 文献[26]将公谈性(fairness), 对等性(equality)和无偏见性(unbiasedness)视为沟通含义并给出如下刻画, 如若对于两个具有沟通的特征但具有不同的敏锐属性(如种族, 宗教或性别等)的不同个体, 模子应作念出沟通的决定. 文献[14]中商量了非歧视性(non- discrimination), 即不详对等地对待统统用户, 而不因社会阶级等信息区别对待, 事实上, 这与文献[26]中的界说是肖似的. 文献[16]中指出系统的公谈性应确保不存在基于任何固有的或得回的与决议无关的特征而对任何个东谈主或群体产生偏见和歧视. 文献[27]指出公谈性的要求包括对相似个体给出相似展望的个体公谈性, 对等对待不同群体的团体公谈性以及对等对待子群的子群公谈性. 文献[48]总结了公谈机器学习算法中的3类公谈性界说, 包括感知公谈性, 统计公谈性和因果公谈性, 这更多是从更细节的算法兑现层面而不是从基于伦理谈德的外部评价层面提供的界说.

综上, 本文将公谈性界说为: AI系统对等对待任何个体、团队或子群, 不因与决议无关的社会学中常见的敏锐属性(如种族, 宗教或性别等)导致任何歧视或偏见的才能. 与公谈性同义的术语包括对等性、无偏见性和非歧视性.

3.4 可解释性原则可解释性对于建立和贵重用户对AI系统的信任至关进击, 可解释性原则要求AI系统的才能和目的需要被公开, 且需要尽可能使径直和辗转受影响的东谈主不详贯通系统的决议过程[10]. 在获取到的质料属性中, 唯唯独个质料属性, 即可解释性不错映射到该原则下. 事实上, 本文识别到了可解释性(interpretability), 可解释性(explainability), 透明性(transparency). 但这三者是近义的, 其汉文献[19, 33]指出“interpretability”和“explainability”在一级辩论中时常被互换使用, 而对“transparency”本质的辩论内容与前两者也莫得本色互异. 是以本文将三者调理归类为了可解释性. 根据这三者在不同辩论中的界说, 它们照实存在一些隐微的互异, 但这体现的是可解释的不同方面或不同进程, 以及不同辩论者刻画的角度. 而本文将详细现存的界说, 对可解释性给出一个更广义的界说. 此外, 可问责性与可解释性的界说肖似, 文献[16]指出可问责性要求监控AI系统的运行从而幸免其变成伤害, 而兑现这少许的要害是要发现为算法崇拜的包袱方, 因此, 本文觉得可问责性强调面对伤害时的包袱问题, 厘清包袱所需的信息与兑现可解释所需的信息存在相通但并不完全沟通. 是以本文将可问责性归为伤害防止原则, 而可解释性归为可解释性原则.

● 可解释性(interpretability/explainability). 有10篇文献[14, 16, 19, 26, 33-35, 41, 44, 51]商量了可解释性或相似倡导. 文献[26, 41]中将“interpretability”刻画为使东谈主类贯通一个模子怎么职责的才能. 文献[26]中将“explainability”刻画为AI系统的里面结构不详以东谈主类不错贯通的方法进行解释的进程. 文献[41]雷同觉得模子的“explainability”与AI系统的里面逻辑关系. 但文献[34]仅使用了“interpretability”一词, 其觉得“interpretability”包含模子透明性和模子功能性两个方面, 其中模子透明性指能否使用输入数据和参数模拟系统决议过程以及模子参数和算法是否不错被用户贯通; 模子功能性则侧重模子的可视化和能否给出局部解释. 事实上, 在文献[34]的界说中, 模子透明性与文献[26, 41]对于“explainability”的贯通基本一致, 而模子功能性与文献[26, 41]对于“interpretability” 的贯通基本一致. 文献[19]也使用了“interpretability”一词, 并觉得“interpretability”有助于揭示哪些特征促使系统的特定输出的产生以及怎么通过模拟系统决议过程以得回决议, 这与文献[26, 41]中对于“explainability”而不是“interpretability”的解释愈加接近. 总体而言, 不错通过现存辩论得到一个相对一致的论断, 即可解释性包含两个方面, 一方面是决议行动的可解释性, 即系统总体和各花样的决议目的、输入、输出不详被东谈主类贯通; 另一方面是里面结构的可解释性, 即系统进行具体决议行动时, 其决议过程不详被东谈主类贯通. 里面结构的可解释性本质与透明性是近义的. 有4篇文献[14, 19, 26, 35]使用了“transparency”一词. 文献[26]指出由于坚苦明确的声明性暗示, 大多数AI系统的里面情状过于不透明导致无法产生具有内在可解释性的元数据, 这里透明性和可解释性之间的互异在于, 前者只需要结构不详被东谈主类不雅测到, 此后者在要求可不雅测的基础上还不详被东谈主类贯通. 文献[14]觉得保险AI系统的透明性不错向用户提供一个清澈的蓝图以匡助用户了了地贯通模子所作念的决议以及了解模子的里面结构; 文献[35]将模子的透明性界说为不详不雅测到模子的参数和展望是怎么生成的. 这两项辩论中界说的透明性与可解释性莫得本色的互异, 仅仅视角的不同. 是以最终本文将“interpretability”“explainability”和“transparency”调理归类为了可解释性, 其包含了子属性透明性.

综上, 本文将可解释性界说为: 可解释性包含两个方面, 一方面是决议行动的可解释性, 即系统总体和各花样的决议目的、输入、输出不详被东谈主类贯通; 另一方面是里面结构的可解释性, 即系统进行具体决议行动时, 其决议过程不详被东谈主类贯通. 其中里面结构可解释性的前提是透明性, 且广大情况下二者的同义的.

3.5 其他的一般软件质料属性本文将无法映射到简直AI的4项基本原则之下的6种质料属性分类到了一般软件质料属性类别中, 以保证端倪结构的无缺性. 这6种质料属性都只在文献[37]中得到了商量, 包括兼容性, 可贵重性, 功能适用性, 易用性, 可移植性和性能效果.

文献[37]在刻画上述质料属性时, 给与了ISO/IEC 25010:2011[63]中的界说. 本文仅作简要转述.

● 兼容性(compatibility)指居品、系统或组件与其他居品、系统或组件在交换信息且分享沟通硬件和软件环境的情况下, 实践其所需功能的进程.

● 可贵重性(maintainability)指居品或系统可通过修改以改进、改造或顺应环境和要求变化的有用性和效果.

● 功能适用性(functional suitability)指在特定条款下使用时, 居品或系统提供炫夸章程和隐含需求的功能的进程.

● 易用性(usability)指在指定的使用环境中, 指定用户不错使用居品或系统来兑现指定主见的有用性、效果和繁盛度.

● 可移植性(portability)指系统、居品或组件可从一个硬件、软件或其他操作和使用环境改变到另一个环境的有用性和效果.

● 性能效果(performance efficiency)指在章程条款下与使用的资源数目相干的性能效果.

RQ2要点总结: 通过数据抽取与合并, 本文得回了21个质料属性, 并整理形成了如图7所示的简直东谈主工智能系统的质料框架. 详细二级辩论中的刻画和界说, 本文调理了每个质料属性的界说性刻画.

4 简直性的评估度量方法(RQ3)在辩论过程中, 本文仅获取到了可解释性, 鲁棒性, 公谈性和阴私性的评估度量方法, 如表5所示. 其他质料属性的评估度量方法均无二级辩论进行过商量. 后文中统统“A”起头的文献辩论均来自二级辩论, 本文整理一级辩论文献内容已在线公开, 可视察网址 https://docs.google.com/document/d/10N5pt0UO-BxPgi7S7oMiLHCEpHRb82zpyaBJftGShPQ获取.

仅有2篇文献[16, 19]商量了东谈主工智能系统可解释性相干的度量方法. 已有辩论提议了不同的可解释性保险方法为东谈主工智能系统生成解释(参见第5.2节), 从而提能手工智能系统的可解释性. 具体而言, 文献[16, 19]商量的都是用于评估模子可解释性保险方法生成的解释的方法和度量. 依据文献[19], 本文将这些评估可解释性保险方法生成的解释的方法分为谋略度量、默契度量和其他解释评估方法3类.

● 谋略度量(computational metrics)广大使用方程和现存数据进行, 不错在莫得东谈主类参与的情况下手脚构建具备可解释性的期间的带领方针[A1], 该度量也被称为是可解释AI系统生成解释质料的数字度量(numeric indicator)[A2]. 文献[19]并莫得夺目商量该度量, 具体定量方法可参考文献[A1,A2].

● 默契度量(cognitive metrics)则是由东谈主类受试者进行评估笃定, 要求受试者从我方的角度笃定最好的解释. 举例, Hoffman等东谈主[A3]从优良性(goodness)、繁盛度(satisfaction)、易贯通性(understanding)和效果度量(efficiency)等4方面商量了常见的度量方法, 这些方法不错匡助受众从我方的角度对生成的解释进行评估, 其中优良性包括清澈度和精度等影响解释利弊的要素, 繁盛度指用户觉得可解释性方法生成的解释匡助他们贯通东谈主工智能系统或过程的进程, 易贯通性与可解释性方法对东谈主工智能系统的解释的精神模子、兴味和信心关系, 效果度量的主见是笃定系统在有用实践期间设想任务产生解释方面的生效进程. 更多具体方法可夺目参考原文献[A4–A7].

● 其他可解释性评估方法. ISO TR 24028[9]中提议了3种对生成解释的度量, 包括一致性, 邻接性和弃取性. 一致性要求对相似的展望产生沟通或相似的解释; 邻接性用来推断输入变量进击性的变化在解释方法的特征分数的反应进程; 弃取性则意味着可解释性方法应该从特征空间中弃取影响最大的特征. Arya等东谈主[A8]根据解释的内容、级别以及生成时势, 将这些方法组织在决议树中. Sokol等东谈主[A9]提议了一份用于系统评估可解释方法的说明书, 根据功能、操作、可用性、安全性和考据维度评估可解释模子.

4.2 鲁棒性评估方法仅有2篇文献[15, 38]商量了鲁棒性的评估方法. 鲁棒性的评估广大是定量的, 举例广大贯通的模子展望性能的评估属于鲁棒性评估.

● 学问趣器学习算法展望性能评估度量. 文献[15]指出常见准确性, 精确度, 调回率和F1得分等性能目的已被辩论东谈主员无为用于各种机器学习算法和应用中, 以对系统大意障碍时的性能进行评价. 举例, Dunn等东谈主[A10]在物联网环境的应用中, 使用准确性, 精确度, 假阳性率和真阳性率4种性能目的来评价投毒障碍对梯度增强, 速即丛林, 朴素贝叶斯和前馈深度学习4种模子无缺性的负面影响; 相应地, 这些目的也可用于评估系统的预防机制, 从而度量系统的鲁棒性. 更多对于这些性能评估度量在评估东谈主工智能系统鲁棒性中的应用方法参考原文献[A11, A12].

● 基于攻防的鲁棒性评估方法. 除常见的展望性能评估除外, 文献[15]中先容了已有的鲁棒性评估方法, 举例Biggio等东谈主[A12]提议了一个劝诫安全性评估框架(empirical security evaluation framework), 该框架由一个不错界说任何障碍场景的对抗模子、相应的数据散布模子以及用于劝诫性能评估的检会集和测试集生成方法构成, 为不同分类器、学习算法和分类任务的安全性评估提供了定量和通用的基础. Katzir等东谈主[A13]提议了一种称为模子鲁棒性评分(model robustness score, MRB score)的度量方法, 该方法基于障碍资本和特征变换资本对障碍者的才能进行建模, 量化应用于蚁集安全的各种机器学习分类器的弹性以评估机器学习模子的相对弹性. 文献[38]指出迷糊测试、故障注入等传统软件的测试期间也被应用于神经蚁集的鲁棒性评估, 举例, Guo等东谈主[A14]提议了一个名为DLFuzz的深度学习系统的差分迷糊测试框架, 该框架不休对输入进行变化, 以最大化神经元掩盖率和原始输入与变异输入之间的展望互异. 更多具体方法请参考原文献[A15–A25].

4.3 公谈性相干度量文献[49]中商量了影响AI系统公谈性的度量. 具体包括互异影响、东谈主口均等、均等几率、契机均等和个体公谈.

● 互异影响度量(disparate impact)[A26]要求对两个群体产生的展望收尾的阳性展望率之间有着较高的比值, 这意味着在不同群体之间的阳性展望比例是附进的. 该目的的数值越高, 则不同群体之间的比率越接近. 根据文献[49], 该度量的谋略公式如下.

$ \frac{{P[\hat Y = 1\mid S \ne 1]}}{{P[\hat Y = 1\mid S = 1]}}{\text{ }} \geqslant {\text{ }}1 - \varepsilon $ (1)其中, $S$ 暗示种族、性别等受保护的属性, $S{ = 1}$ 为特权(展望收尾的阳性展望率较高)群体, $S \ne 1$ 则暗示非特权群体, $\hat Y= 1$ 暗示展望收尾为阳性.

一种典型的互异影响度量是Feldman等东谈主[A26]提议的“80%司法(rule)”, 该司法要求任何种族、性别或群体(即敏锐属性)的接受率至少为接受率最高群体的80%以上.

● 东谈主口均等度量(demographic parity)的度量方法与互异影响肖似, 但在度量时给与的是互异而不是比值[A27]. 该度量的谋略公式为:

$ |P[\hat Y = 1{\text{ }}\mid S = 1] - P[\hat Y = 1{\text{ }}\mid S \ne 1]|{\text{ }} \leqslant {\text{ }}\varepsilon $ (2)文献[49]指出互异影响度量和东谈主口均等度量这两种度量方法存在一定的舛误, 因为当不同群体之间的本质阳性收尾显耀不同期, 一个完全准确的分类器可能会被度量为不公谈.

● 均等几率度量(equalized odds)[A28]谋略假阳性率(false-positive rates, FPRs)以及两个群体之间的真阳性率(true-positive rates, TPRs)的互异以克服上述互异影响度量和东谈主口均等度量的舛误. 该度量不错通过如下公式谋略.

$ |P[\hat Y = 1{\text{ }}\mid S = 1, {\text{ }}Y = 0] - P[\hat Y = 1{\text{ }}\mid S \ne 1, {\text{ }}Y = 0]|{\text{ }} \leqslant {\text{ }}\varepsilon $ (3) $ |P[\hat Y = 1{\text{ }}\mid S = 1, {\text{ }}Y = 1] - P[\hat Y = 1{\text{ }}\mid S \ne 1, {\text{ }}Y = 1]|{\text{ }} \leqslant {\text{ }}\varepsilon $ (4)其中, 公式(3)和公式(4)分别要求两个群体之间假阳性率和真阳性率的差的全都值以 $\varepsilon $ 为界.

● 契机均等度量(equal opportunity)要求不同群体之间的真阳性率相似[A28], 该度量与均等几率度量肖似, 但只温情于真阳性率. 该度量的谋略公式如公式(5)所示.

$ |P[\hat Y = 1{\text{ }}\mid S \ne 1, {\text{ }}Y = 1] - P[\hat Y = 1{\text{ }}\mid S = 1, {\text{ }}Y = 1]|{\text{ }} \leqslant {\text{ }}\varepsilon $ (5)● 个体公谈度量(individual fairness)要求相似的个体受到相似的对待. 该度量在界说公谈性时不仅洽商敏锐属性, 还洽商个体的其他属性[A29]. 个体公谈度量不错用公式(6)刻画.

$ \left| {P\left( {{{\hat Y}^{(i)}} = y{\text{ }}\mid {X^{(i)}}, {\text{ }}{S^{(i)}}} \right) - P\left( {{{\hat Y}^{(j)}} = y{\text{ }}\mid {X^{(j)}}, {\text{ }}{S^{(j)}}} \right)} \right| \leqslant \varepsilon ;\;\;{\text{ if }}\;\;d(i, j) \approx 0 $ (6)其中, $i$ 和 $j$ 分别暗示两个个体, ${S^{( \cdot )}}$ 暗示个体的敏锐属性, ${X^{( \cdot )}}$ 暗示与敏锐属性相干的属性, ${{d(i, j)}}$ 为根据预期用途界说的相似度的距离度量.

文献[A30]指出要对个体之间的相似性进行度量, 还需要洽商特征和标签之间关系的假定.

4.4 阴私性评估方法仅有一项辩论[45]商量了阴私性的度量方法. 文献[45]商量了一级辩论中使用差分阴私来评估阴私性风险的方法. 举例, McSherry[A31]基于差分阴私的可组合性, 通过谋略阴私消费的总额来度量阴私性风险. Abadi等东谈主[A32]给与圭臬Markov不等式来追踪阴私耗损, 在劝诫上得回愈加严格的阴私损误期束. 文献[45]指出, 上述方法仅限于使用差分阴私框架的系统. Long等东谈主[A33]提议了差分阴私检会(DPT)的方法, 该方法不错用于评估未使用差分阴私方法的分类器的阴私风险. 差分阴私方法更多地被应用于AI系统的阴私性保险, 本文将在后续章节对这一用途进行商量.

RQ3要点总结: 本文识别到了可解释性, 鲁棒性和公谈性的相干评估度量以及鲁棒性和阴私性的评估方法. 对于其他质料属性的度量和评估方法, 现存二级辩论鲜有商量. 对于识别到的度量方法, 现存二级辩论中的商量也较为愚顽, 读者仍需以本文或相干二级辩论为进口, 从相干一级辩论中得回更详备的信息.

5 简直性的保险改进实践(RQ4)现存二级辩论中, 仅有7种质料属性的保险改进实践或方法被商量了, 分别是安全性, 鲁棒性, 可解释性, 阴私性, 公谈性, 可问责性和东谈主类代理和监督. 其中安全性和鲁棒性难以作出明确的区分, 因为雷同的实践或方法可能在有些文献中被觉得是保险安全性的, 而在另一些文献中被觉得是进步鲁棒性的, 而它们所抒发的含义是沟通的, 是以本文将安全性及鲁棒性的实践一皆商量. 本文将实践界说为一个譬如法更抽象的倡导, 即一类实践可能包含多种兑现方法. 本节将分别对每种质料属性的保险改进实践及相干方法伸开先容.

5.1 安全性及鲁棒性相干实践共有12篇文献[14, 15, 17, 24, 25, 28, 31, 36, 40, 43, 45, 50]商量了安全性及鲁棒性相干的保险实践或方法. 对于AI系统, 常见的且被现存辩论商量的障碍方法包括对抗(躲避)障碍、投毒障碍和模子窃取[15, 17, 25, 43, 45], 按照所大意的障碍种类的不同, 本文将统统的方法分类为投毒障碍预防、对抗障碍预防、模子窃取预防和与障碍无关的模子优化实践共4类, 如表6所示.

● 投毒障碍预防. 投毒障碍是基于一种愚弄受轻侮数据进行学习的念念想发展起来的障碍时势[15]. 障碍者将受轻侮的数据或样本植入到检会集合以戒指检会数据的散布, 从而破损模子或使模子得出失实的收尾[43]. 文献[50]指出投毒障碍主要有两种障碍时势: 一种是通过植入轻侮数据影响系统的领域, 从而破损系统的可用性; 另一种是生成后门从而破损系统的无缺性. 相应地, 投毒障碍预防实践也包含2种不同类型的大意方法, 即数据圭臬化和后门障碍检测. 数据圭臬化的念念想是将脑怒样本从正常样本等分离出来, 然后去除这些坏心样本以保证检会数据的纯度[40]. 后门障碍检测的念念想是检测障碍者植入的后门触发器. 可是, 由于唯独当存在后门触发器时才会触发坏心行动, 且后门触发器在触发前唯独障碍者知谈, 因此后门障碍检测极具挑战性[43].

● 对抗障碍预防. 对抗障碍发生在AI系统的应用阶段, 其基本念念想是构造促使AI模子产生失实分类的对抗样例[43]. 以一般的分类器为例, 投毒障碍改变的是模子的分类领域, 而对抗障碍则是将输入的样本修改为失实的类别[25]. 对抗障碍预防实践包括对抗样本检测、对抗检会、预防蒸馏等7种具体的方法. 对抗样本检测基于二分类念念想, 愚弄检测器将系统的输入分为原始输入和对抗样本两类[36]. 对抗检会旨在提高系统的鲁棒性, 中枢念念想是将对抗样本加入原始检会数据集合进行检会, 使检会后的模子不详学习对抗样本的特征[36, 43, 45]. 预防蒸馏是神经蚁集大意对抗障碍的一种方法, 该方法使用蒸馏的时势裁减DNN的谋略复杂度[43, 45]. 数据处理通过改变或调遣输入的花样及特征以大意对抗障碍[43, 45]. 梯度正则化(或称梯度遮盖)方法通过修改输入数据的梯度、耗损函数或激活函数来增强模子的鲁棒性[15]. 预防蚁集是使用神经蚁集等器具对对抗样本进行自动对抗的方法[45].

● 模子窃取预防. 模子窃取是一种查询主见模子并愚弄其功能的障碍时势[43]. 文献[A57,A58]提议了一种荫藏式安全方法, 即一种通过向障碍者荫藏信息以预防障碍者查询主见模子的方法.

● 模子优化. 文献[31]中指出提高模子的可解释性和给与AutoML也不错手脚预防计谋. 提高模子的可解释性有助于开发东谈主员贯通模子决议背后的原因, 从而识别系统的缺欠和不及以进行预防. AutoML旨在匡助模子弃取最优的值和权重来进行检会, 从而进步模子预防各种障碍的才能.

5.2 可解释性相干实践共有10篇文献[14, 16, 19, 24, 33-35, 41, 44, 51]商量了可解释性相干的保险实践或方法. 如表7所示, 本文将相干实践分别为3类, 包括预建模、建模时、建模后的可解释性保险实践.

● 预建模可解释性保险. 文献[16]指出为AI系统提供可解释性的一种方法是解释系统的检会数据集[16], 其要求在开发模子前, 探索和贯通检会系统所需的数据集从而为系统提供预先解释. 举例, 不错在使用数据前给与可视化期间扶植贯通数据, 这类期间不详匡助系统的设想和开发东谈主员更好地贯通数据集合各种属性的散布, 从而更好地贯通系统的模子. 通过预建模可解释性保险实践提供的可解释性也被称为预先可解释性(ex-ante explainability)[16].

● 建模时可解释性保险. 在建模时, 不错有意创建可解释的或容易贯通的模子, 即创建白盒模子的方法[41]. 一个透明的可解释的模子应该不详从全体上被完全贯通, 同期也应使东谈主能模拟出模子的谋略过程[44]. 决议树、线性模子和基于司法的模子等模子族均能提供较好可解释性. 不外瓦解, 唯独部分复杂度不高的模子不详炫夸可解释性的要求, 即建模时可解释性保险具有瓦解的局限性[16].

● 建模后可解释性保险. 这类实践保险的是系统的过后可解释性(post-ante explainability), 即解释检会后的模子[44]. 现存辩论商量到的可解释性实践大部分属于这类实践, 有多种兑现方法, 包括基于实例的方法, 基于司法的方法, 基于可视化的方法, 基于代理的方法以及基于传播的方法等. 基于实例的方法通过解释系统的具体实例, 即从输入数据集合弃取部分实例并监控它们的输出以提供系统的可解释性[16, 19]. 基于司法的方法广大应用于神经蚁集, 这类方法通过从已检会的模子中索取解释司法等信息来提供可解释性[16, 44]. 基于可视化的方法通过将蓝本不透明的AI系统的里面职责进行可视化来提供可解释性[16, 19]. 基于代理的方法通过创建与黑盒模子肖似的通俗模子以保险可解释性[19]. 基于传播的方法适用于基于神经蚁集构建的系统, 其基于反向传播和正向传播, 通过对扰动特征后的输出互异量化系统的特征, 从而达到进步可解释性的目的[19].

5.3 阴私性相干实践有16 篇文献[15, 16, 18, 24, 25, 28-30, 36, 39, 40, 42, 43, 45-47]商量了阴私性的保险实践或方法. 具体不错分别为差分阴私, 同态加密, 安全多方谋略, 去识别期间, 联邦学习, 数据降维, 函数加密共7类实践, 如表8所示.

● 差分阴私是一类典型的基于扰动的方法, 其通过向数据中加入噪声以减少个东谈主信息走漏的阴私风险[15, 29]. 根据添加噪声的阶段不同, 差分阴私不错更具体地分为输入扰动方法, 参数扰动方法, 主见函数扰动方法和输出扰动方法4类. 输入扰动方法是对数据集进行预处理, 通过向原始数据添加噪声以幸免模子战斗到用户的真实数据[46]. 参数扰动是梯度级的扰动方法, 通过向参数中添加噪声幸免阴私信息走漏[29, 36]. 主见函数扰动也被简称为函数扰动, 主要方法是向主见函数或主见函数的伸开式统共中添加噪声[29]. 输出扰动是对检会后的模子参数添加噪声或模子展望后的输出收尾添加噪声以幸免模子受到索取障碍或推断障碍的方法[29, 46].

● 同态加密是一种愚弄加密算法的实践, 加密的主见是允许对密文进行随便运算, 且解密后的收尾与明文运算一致[15, 40]. 具体依据加密主体的不同, 同态加密不错分为检会数据加密和模子加密两种. 文献[39]中指出, 在检会过程中加入同态加密会使得检会至少慢上一个数目级, 因此其常常用于检会通俗分类器时. 模子加密则是对模子的梯度、参数等进行加密以保护阴私的方法, 举例Gilad-Bachrach等东谈主[A186]将实数编码到多项式中并进行非线性函数的低次多项式靠近, 以保护伞经蚁集的阴私性.

● 安全多方谋略与同态加密同属基于加密的阴私保护实践[39]. 安全多方谋略是加密期间在多方场景下的彭胀, 主要用于在不浮现两个或多个参与方的个东谈主信息的前提下, 谋略得出各参与方的集合函数[15]. 文献[39]指出多方安全谋略一般组合使用加密和渐忘传输, 在单个组件不行见的情况下由各方私行完成谋略, 这不错保证谋略模子的更新而不需要视察数据和模子[39]. 举例, Mohassel等东谈主[A196]愚弄速即梯度下跌方法和多方谋略的巧妙分享成就, 引入了SecureML以兑现两方谋略场景下的逻辑精致和神经蚁集的私东谈主检会. Mehnaz等东谈主[A197]提议了一个基于安全和谋略的通用框架, 该框架使得多方不详以阴私保护的时势对分割数据进行检会. 更多多方安全谋略的具体方法夺目参原谅文献[A198–A215].

● 去识别期间通夙昔除数据中存在的径直或辗转的身份象征偏激关联关系以保护个体阴私[16]. 举例, Garfinkel等东谈主[A216]提议使用数据抽样和团员兑现基于样簿子集或汇总版块来暗示数据, 该方法不详幸免发布无缺数据集带来的风险, 进而兑现对数据的去识别. Khail等东谈主[A217]提议了一种称为阻难期间的屏蔽期间来屏蔽敏锐属性的值, 达到去识别化的目的. 更多具体方法夺目参原谅文献[A218–A221].

● 联邦学习的中枢念念想是模子在用户自有的开采上进行检会后再进行分享, 通过这种联接学习的机制不详在一定进程上保护用户原始数据的阴私[16, 43]. Geyer等东谈主[A222]提议了一种在散布式学习场景下贵重用户数据的联邦学习框架, 该框架不错保护用户级别的差分阴私. Hao等东谈主[A223]提议了一种名为PEFL (privacy enhanced federated learning)的联邦学习方法, 以裁减分享参数被敌手愚弄的风险. Konečný 等东谈主[A224]提议了一种愚弄团员进行联接学习的联邦学习框架, 以提高联邦学习场景下通讯的效果.

● 数据降维通过将高维数据映射到低维以幸免障碍者重建数据或推断数据中的敏锐信息[15]. Hamn[A226]提议了一种基于数据将为的预防方法, 该方法作用于模子的检会阶段, 不错在保留主见任务信息的同期, 删除数据中的敏锐属性, 从而使得敌手难以从输出中推断用户的阴私性数据.

● 函数加密与同态加密肖似, 区别在于数据的加密方不错通过使用与谋略收尾关联的密钥进行解密, 这么只会走漏谋略的收尾而不会走漏原始数据的任何信息[15]. Sans等东谈主[A227]展示了一种用于MNIST数字的分类器, 该分类器基于一个具有二级激活函数的隐层神经蚁集, 通过解密密钥允许就业器学习分类的收尾. Marc等东谈主[A228]提供了一个开源的函数式加密库, 兑现了机器学习中包括内积、基于属性的秘密等常用的函数加密原语.

5.4 公谈性相干实践有5篇文献[14, 16, 27, 48, 49]商量了公谈性相干的实践和方法. 对于公谈性的质料保险实践, 本文根据作用于模子处理阶段的不同将这些实践映射为预处理机制, 处理中机制和处理后机制共3类, 如表9所示.

● 预处理机制是在模子检会之前对数据集进行预处理以确保数据不会存在偏见或歧视, 进而保险公谈性[16]. 文献[48]将这类实践的任务称为公谈表征任务, 这类任务的主见是使输入的特征仅保留与展望主见关系的信息, 而清除与展望主见无关的个体特征, 从而索取出公谈特征以建立公谈数据集. 举例, Xu等东谈主[A229]提议的FairGAN模子不详通过两个特征蚁集, 在保险公谈性的前提下生成特征, 以保证生成的特征与原始数据以及不同群体的属性散布均相似. Kamiran等东谈主[A230]提议了一种通过改变一些实例的标签或权重从而使得分类器愈加公谈的方法. 更多具体方法夺目参原谅文献[A26,A231–A249].

● 处理中机制通过修改决议算法或模子以防止和松开偏见对公谈性的影响[16]. 文献[48]将这类实践的任务视为公谈建模任务, 这类任务的主见是改进算法模子, 在保证准确性的同期保险模子的公谈性. 举例, Berk等东谈主[A250]提议了一种使用个体公谈、群体公温柔组合公谈3个正则化项对耗损函数进行加权以兑现公谈精致算法的方法, 该方法在提供个体公温柔群体公谈的同期, 不详谋略出保险公谈性对展望准确性的影响. Lepri等东谈主[A251]建议由多学科行家团队对算法进行审查, 以保证算法一碗水端平. 更多具体方法夺目参原谅文献[A27,A252–A278].

● 处理后机制通过对系统的输出进行后置处理以摒除决议中存在的偏见以保险决议的公谈性[16]. 文献[48]将这类实践的任务称为公谈决议任务, 这类任务的主见是对决议收尾进行诊治以确保决议对每个群体是公谈的. 举例, Menon等东谈主[A279]建议通过对不同群体的主见函数使用不同的阈值以减少决议中可能出现的偏见. 肖似的, Dwork等东谈主[A280]提议了一种对不同群体使用不同分类器的解耦期间用于减少偏差. 更多具体方法夺目参原谅文献[A28,A281–A284].

5.5 可问责性相干实践有2篇文献[14, 16]商量了可问责性的相干保险实践/方法. 在进行方法分类时, 本文华纳了文献[16]中对于可问责性保险实践的分类, 分为预建模(ex-ante)可问责性保险, 建模时(in-ante)可问责性保险, 建模后(post-ante)可问责性保险方法, 如表10所示.

● 预建模可问责性保险实践是在算法本质开发之前的规画和设想阶段, 为系统所作念的决定进行包袱分派, 这类方法还不错用于清澈地刻画统统径直或辗转受系统影响的用户[16]. 这类实践有好多更具体的方法, 举例, 通过优先级排序来措置利益破碎问题并兑现更好地治理和问责[A285]. Broeders等东谈主[A286]提议了一种时候框架机制(time frame mechanism), 该框架通过在设想过程中实时再行评估系统, 以确保按照预期的模范和指南职责, 从而幸免变成潜在的伤害. 还有辩论东谈主员[A287,A288]指出列明统统的设想模范并了了地刻画系统在不怜悯况下的行动, 有意于更好的治理和问责.

● 建模时可问责性保险实践是在AI系统的开发阶段采选措施保险可问责性[16]. 这类实践料理AI系统统统这个词开发阶段(含测试、评估等), 在确保系统炫夸其他质料属性的同期保证系统不详向用户评释其所作念决议的才能. 文献[16]指出具体的建模时实践包含3个花样, 启程点确保检会数据莫得偏见[A289–A291], 然后根据问题弃取合适的算法模子[A292,A293], 临了在系统部署之前进行测试[A294].

● 建模后可问责性保险实践在模子或系统部署之后措置可问责性问题[16]. 这类实践包括一些审计期间或框架. 举例, Kroll等东谈主[A294]提议了一个框架用于确保部署的模子不详在指定的领域内职责. Raji等东谈主[A295]提议了一种用于算法审计的框架, 该框架手脚一个里面审计框架, 救济行家对开发过程的每个花样进行审计, 有助于在问题发生前进行防止或发生后进行缓解. LeBrie等东谈主[A296]提议一个可用于AI系统外部考据的谈德审计框架, 用于匡助部署的AI系统幸免偏差和失实. 更多具体方法夺目参原谅文献[A297–A299].

5.6 东谈主类代理和监督相干实践仅有1篇文献[14]商量了东谈主类代理和监督的相干保险实践/方法. 根据该文献, 本文将这些保险方法映射到东谈主机联接机制下.

● 东谈主机联接机制旨在通过东谈主类的参与来提能手工智能系统的信任度和准确性[14]. 举例, Veeramachaneni等东谈主[A300]引入了一个用于入侵检测的分析在环(analysis-in-loop)的AI系统, 该系统从安全分析师那边获取反馈, 以减少系统的误判. Kaur等东谈主[A301]提议了一种东谈主机联接机制用于戒指视察和机器之间的交互, 以提高违警热门检测的准确性. 更多夺目方法参原谅文献[A302–A306].

RQ4要点总结: 本文获取到了安全性, 鲁棒性, 可解释性, 阴私性, 公谈性, 可问责性以及东谈主类代理和监督共7个质料属性的质料保险改进实践. 其中, 现存二级辩论中对安全性, 阴私性和可解释性的保险改进实践的总结更为系统、全面, 而可问责性与东谈主类代理和监督的保险改进实践则相对单薄.

6 讨 论本节将基于辩论收尾, 从辩论近况、质料属性与实践两个方面进一步伸开商量, 并识别潜在的辩论标的.

6.1 辩论近况● 现存二级辩论掩盖较为全面, 但焦点具有相配强的倾向性. 图5状貌了简直AI的辩论范围元模子, 现存辩论从高抽象级的简直到细粒度的实践、方法和器具, 均有所掩盖. 可是, 现在已有的二级辩论在简直的温情点以及辩论端倪上散布并不平衡. 大部分辩论温情于简直的挟制与挑战, 以及相应的保险改进实践, 尤其温情的是安全性和阴私性的相干问题. 安全性和阴私性均属于伤害防止原则中的质料属性. 相较于与伦理谈德密切相干的尊重东谈主类自治原则和公谈性原则, 伤害防止原则的适用范围更广, 因为并不是每一种AI系统都会面对伦理谈德的磨真金不怕火, 比如软件工程领域中被无为辩论的基于AI的舛误展望系统现在并不触及尊重东谈主类自治原则和公谈性原则中的问题, 但其会触及伤害防止原则中的安全性、鲁棒性等问题. 表4对现存辩论的辩论问题进行了整理, 看起来每种辩论对象都被掩盖了, 但具体到各个质料属性, 还有特等大的空缺; 具体到不同粒度的辩论问题, 温情于How层面的辩论相配少, 这一定进程上是二级辩论的抽象进程决定的, 但特等多的辩论问题都是停留在What层面的, 更真切的二级辩论是辩论者们改日不错温情的标的.

● 简直的范围太广, 术语的一致性问题是辩论的进击紧闭. 由于广大会对系统的展望性能进行评估, 绝大部分AI系统的一级辩论都会触及鲁棒性的问题. 展望性能的评估方法也一直是一个被辩论者们温情的问题. 但在本文纳入的34篇文献中, 仅有2篇文献商量了鲁棒性. 一些对于展望性能评估方法的辩论, 举例文献[64], 是不包含鲁棒性等要害词的. 由于术语的问题, 确实饱和全面地开展简直相干的二级辩论以及三级辩论是悲惨的. 另一个被辩论较多的质料属性是可解释性, 自深度学习期间出生以来, 可解释性就一直是一个使其备受争议的问题, 是以可解释性得回较高的温情度亦然铿锵有劲的. 可是, 正如第3.4节中商量的, 可解释性的术语也并不调理. 这些都会使辩论者想要了解相干信息, 以至是开展一项二级辩论时, 未免有直快. 本文的一个进击价值, 正在于梳理与简直相干的辩论范围偏激术语倡导, 为简直相干的辩论提供定位.

● 现存二级辩论的质料唠叨不皆. 在数据抽取的过程中, 本文发现所获取到的二级辩论所给与的辩论方法大多莫得降服系统性文献综述(SLR)或系统性文献映射(SMS)等愈加严谨的综述方法[13]. 在Kitchenham等东谈主[23]将基于凭证的软件工程(evidence based software engineering, EBSE)引入软件工程辩论领域后, SLR和SMS仍是成为软件工程领域开展二级辩论的主要辩论方法. 在获取到的文献中, 仅有2篇文献[24, 37]基本降服了SLR或SMS的模范, 这可能会给二级辩论的无缺性和有用性带来一定的挟制, 举例, 对于文献检索要害上, 大部分辩论莫得降服模范的文献检索计谋, 这可能会导致要害文献的遗漏, 进而导致二级辩论的辩论收尾不够无缺. 从它们最终纳入分析的一级辩论也可见一斑, 举例辩论[A33,A46,A60,A61]未发表到同业评审的会议或期刊上. 这些二级辩论的质料, 也会一定进程上对本辩论的收尾产生一定的挟制.

● 多学科和会的二级辩论太少. 东谈主本主义是对AI简直提议要求的进击依据. 可是, 由于东谈主本主义不属于谋略机相干学科, 是以仅有两篇文献[16, 26]商量了东谈主本主义与AI系统之间的关系, 但文献[26]是一篇随笔, 内容浅尝辄止, 仅商量了东谈主本主义和可解释性、公谈性等质料属性之间的关系. 文献[16]中对于东谈主本主义的商量主要鉴戒了《简直AI伦理指南》[10]. 相较于一般软件系统, AI系统的简直中特等多的问题都源于东谈主类社会对其提议的要求. 对于简直的评估、保险和改进, 最终都需要承袭社会环境的考据. 多学科的和会是悲惨的, 但连年来各学科的和会果决是学术界的一大趋势, 对于AI系统简直的辩论, 学科和会是必不行少的.

6.2 质料属性与实践● 模子、AI系统、一般软件系统之间的辩论界限问题. 在第3节中不错看到, 对于雷同的质料属性, 如安全性, 文献[25]系统角度商量了安全性的3个子主见, 即守密性, 无缺性和可用性. 文献[26]分别从系统角度和模子角度商量了安全性. 而文献[37]仅从一般软件系统的角度商量了安全性. 从这3项辩论中不错看出从模子、AI系统、一般软件系统等不同的角度辩论安全性, 侧重是不同的, 举例对于一般软件系统, 如文献[65]在辩论怎么保险守密性, 无缺性和可用性3个安全性子主见时, 常常从系统全体启程洽商授权, 认证等问题, 而对于AI模子而言, 辩论的温情点常聚焦于投毒障碍, 对抗障碍等针对AI模子的障碍方法上[26]. 可是, 并不是对于统统质料属性的辩论, 辩论者们都作念出了清澈的界定. 举例, 文献[14]和文献[16]均辩论了可问责性, 前者是从模子角度界说可问责性, 后者是从系统角度进行界说, 但两者所刻画的内容实质上是沟通的. 可重复性、阴私性、公谈性等多个质料属性都存在肖似的问题. 本文觉得, 模子手脚系统的一部分, 系统的简直是包含模子的简直的. 在ISO/IEC 25010:2011[63]中指出的适用于一般软件系统的质料属性, 如安全性, 在AI系统会因为AI模子而面对新的问题. AI系统既包含一般软件系统的安全性问题, 也包含AI模子的安全性问题, 还可能包含模子和软件间的交互而产生的其他问题, 是以这三者并不等价. 而对于可重复性、阴私性、公谈性等AI系统所专有的问题, 广大情况下, 辩论中指代为模子或系统, 其含义是沟通的.

● AI系统与一般软件系统简直的辩论与互异问题. 对于5种属于一般软件系统简直的质料属性兼容性, 可贵重性, 功能适用性, 可移植性, 性能效果, 仅有一篇文献[33]进行了辩论, 且给与了ISO/IEC 25010:2011[63]中的界说. 由于坚苦其他的干证, 且文献[37]仅辩论了AI系统中保险上述质料属性开展的实践, 而未与一般软件系统的简直实践进行对比. 是以两者是否有互异, 存在哪些互异, 还有待进一步辩论.

● 对于简直的评估度量的二级辩论较少. 仅有6篇文献[15, 16, 19, 38, 45, 49]辩论了共4个质料属性的评估度量问题. 有用的评估各质料属性是评估简直的前提, 而对于简直的评估是得回用户及监管方信任的前提. 在改日的辩论中, 这是一个值得探索的标的, 亦然一个应该被填补的空缺.

7 效度挟制本三级辩论的辩论过程中存在的效度挟制主要来自文献蚁集、数据抽取与合成以及数据分析中要害中潜在的风险.

● 文献蚁集. 文献蚁集要害的主要风险来自简直AI质料属性相干文献的遗漏. 为了松开这一风险, 一方面, 咱们通过手动检索笃定了检索字符串并明确文献的纳入/清除圭臬, 并基于笃定的检索字符串在4个在线数字藏书楼(IEEE Xplore, ACM Digital Library, ScienceDirect, Scopus)中进行了自动检索; 另一方面, 根据Wohlin[57]的建议, 咱们在谷歌学术上进行迭代式的滚雪球过程, 以查验是否有任何遗漏的辩论. 此外, 为幸免文献筛选过程中由于个东谈主偏见激励的失实, 每一篇文献均由两位辩论生稳固进行筛选共两次, 然后由他们的导师的进行审核.

● 数据抽取与合成. 这一要害中的风险主要包括遗漏有价值的文本和数据抽取中的个东谈主偏差两方面. 为缓解这一风险, 每一篇文献都由一位辩论生进行抽取并由另一位辩论生进行考据. 此外, 在数据抽取的过程中, 他们的导师如期提供带领, 并对疑问或有争议的部分进行解答. 在数据合成的过程中, 由两位辩论生稳固进行, 并由他们的导师审查并商量破碎或不笃定的内容.

● 数据分析. 在数据分析过程中, 东谈主工偏差可能会对论断的有用性产生挟制. 为了松开这种挟制, 两名辩论生及他们的导师组织了几次头脑风暴会议, 商量主题的分类方法以及论断的组织局势.

尽管在辩论职责的各个要害, 咱们均采选措施隐秘有用性风险, 但事实上仍有一些效度挟制未能得到措置. 举例, 欧盟的《简直AI伦理指南》[10]的7项基本要求中有各种性(diversity), 非歧视(non-discrimination)和公谈(fairness)的要求, 但各种性并未在蚁集到的二级辩论中有所商量. 此外, 所获取二级辩论自己也存在着一定的效度挟制, 这雷同会对辩论收尾产生影响. 本文尽可能地基于现存辩论提供AI简直的全貌, 跟着相干领域的发展, 咱们可能在改日需要阶段性地更新简直AI的质料框架. 辩论者们不错针对本文所识别的辩论近况中的空缺, 开展改日的职责.

8 总 结本文着眼于界说、评估和保险AI系统的简直性, 针对简直所需炫夸的质料属性及相干的评估度量方法和保险改进实践等方面, 开展了一项三级辩论. 通过对2022年3月前的文献进行检索, 最终蚁集并详细分析了34项二级辩论. 本文分析和商量了相干二级辩论的近况, 提议了一个简直东谈主工智能辩论范围元模子供改日的辩论者们对简直相干的辩论进行定位. 此外, 本文分析和梳理了与简直相干的质料属性及相干实践和方法lissa_sex5 chaturbate, 提议了一个简直东谈主工智能系统的质料框架, 并详细现存辩论中的刻画, 对简直相干的21种质料属性提供了更准确的界说. 基于辩论的收尾, 本文对发现的问题和改日潜在的辩论标的进行了商量. 其中, 本文觉得最要害的两方面问题, 都是学科和会的问题. 简直AI系统是一个跨学科的辩论标的. 简直的要求源于社会科学, 简直AI模子的评估和保险需要基于谋略机、东谈主工智能、大数据等多学科的合作, 而系统层面的简直又属于软件工程问题. 现存二级辩论中存在两处瓦解辩论不及, 一方面AI系统手脚一种特定软件系统, 与一般软件系统的互异与辩论有待真切辩论; 另一方面, 怎么从系统层面保险机器在社会环境下的简直, 如奈何炫夸东谈主本主义, 有待真切辩论.